Table of Contents

Regression

Lineare Regressionsanalyse

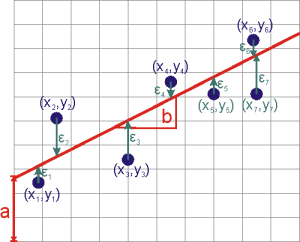

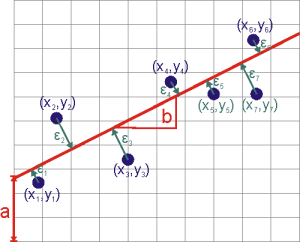

Bei der Linearen Regressionsanalyse wird die Gerade $f(x) = a + bx$ gesucht, die am besten mit den Messwerten $(x_i,y_i)$ übereinstimmt. Die $x_i$ werden dabei als fehlerfrei angenommen und die Gerade so angepasst, dass die Abweichung (Residuen) $\epsilon_i = y_i - f(x_i)$ im Quadrat in der Summe minimal werden.

Formeln

Für den Fall dass die Fehler $\sigma_i$ der $y_i$ identisch sind1) erhält man

\[ a = \frac{1}{\Delta}\left( \sum_i x_i^2\sum_i y_i - \sum_i x_i \sum_i x_iy_i \right) \qquad b = \frac{1}{\Delta}\left( N\sum_i x_iy_i - \sum_i x_i \sum_i y_i \right) \] \[ \Delta = N\sum_i x_i^2 - \left(\sum_i x_i\right)^2 \]

Der Fehler der Schätzung (Standard Error of the Estimate, Mean Square Error) 2)

\[ \sigma_y^2 = \frac{1}{N-2}\sum\limits_{i=1}^N\left(f(x_i)-y_i\right)^2 = \frac{1}{N-2}\chi^2 \]

gibt an, wie stark die Messwerte $y_i$ um die Gerade $f$ schwanken.

Die Koeffizienten $a$ und $b$ sind ebenfalls mit einer Unsicherheit behaftet

\[ \sigma_a^2 = \frac{\sigma_y^2}{\Delta}\sum_ix_i^2 \qquad \sigma_b^2 = N\frac{\sigma_y^2}{\Delta} \]

Das Bestimmungsmaß $R^2$ ist das Quadrat des

Korrelationskoeffizienten $R$:

\[ R^2 = 1 - \frac{\chi^2}{\sum_i \left( y_i - \overline y\right)^2} \]

$R^2$ kann auf zwei Arten interpretiert werden:

- $R^2$ gibt an, wie groß die Abweichung der Messwerte von der Gerade $f$ im Vergleich zur Varianz der Messwerte ist.

- $R^2$ gibt an wie stark die Abweichung der Messwerte von der Geraden $f$ im Vergleich zur Abweichung von einer Geraden parallel zur $x$-Achse ist.

Daraus folgt, dass $R^2$ um so näher bei 1 ist

- je kleiner die quadratische Abweichung der Messwerte von der Geraden $f$ ist

und/oder - je stärker die Steigung der Geraden $f$ von einer Geraden parallel zur $x$-Achse abweicht, d.h. je steiler die Gerade $f$ ist3).

Herleitung / Berücksichtigung von Fehlern in y

Die einzelnen Messwerte $y_i$ weichen um einen Fehler (Residuum) $\epsilon_i$ von der Gerade ab. \[ y_i = f(x_i) + \epsilon_i \]

Das Maß der Übereinstimmung wird durch den quadratischen Fehler4) für jeden einzelnen Messwert bestimmt. Dabei wird angenommen, dass der Fehler der $x_i$ verschwindend gering ist und der Fehler $\sigma_i$ der $y_i$ einer Gaußschen Statistik folgt. [485Bevington, P. R., & Robinson, K. D. (2002). Data reduction and error analysis for the physical sciences 3rd ed. Mcgraw-Hill Higher Education.] (Kapitel 6).

Die Abweichungen von der Gerade werden mit der jeweiligen Streuung der Messwerte gewichtet und aufsummiert.

\[ \chi^2 = \sum_i\left(\frac{\epsilon_i}{\sigma_i}\right)^2 = \sum_i\left(\frac{f(x_i)-y_i}{\sigma_i}\right)^2 = \sum_i\left(\frac{ax_i+b-y_i}{\sigma_i}\right)^2 \]

Die Parameter $a$ und $b$ werden so gewählt, dass $\chi^2$ minimal wird, d.h.

\[ \frac{\partial \chi^2}{\partial b} = 0 \quad\Rightarrow\quad \sum_i2\left(ax_i+b-y_i\right) = 0 \qquad\qquad \frac{\partial \chi^2}{\partial a} = 0 \quad\Rightarrow\quad \sum_i2\left(ax_i+b-y_i\right)x_i = 0 \]

Das lineare Gleichungssystem

\[ \left( \begin{array}{cc} \sum_i\frac{1}{\sigma_i^2} & \sum_i\frac{x_i}{\sigma_i^2} \\\\ \sum_i\frac{x_i}{\sigma_i^2} & \sum_i\frac{x_i^2}{\sigma_i^2} \end{array} \right) \left( \begin{array}{c} a \\\\ b \end{array} \right) = \left( \begin{array}{c} \sum_i\frac{y_i}{\sigma_i^2} \\\\ \sum_i\frac{x_iy_i}{\sigma_i^2} \end{array} \right) \]

kann nach $a$ und $b$ aufgelöst werden.

\[ a = \frac{1}{\Delta}\left( \sum_i\frac{x_i^2}{\sigma_i^2}\sum_i\frac{y_i}{\sigma_i^2} -\sum_i\frac{x_i}{\sigma_i^2}\sum_i\frac{x_iy_i}{\sigma_i^2} \right) \qquad b = \frac{1}{\Delta}\left( \sum_i\frac{1}{\sigma_i^2}\sum_i\frac{x_iy_i}{\sigma_i^2} -\sum_i\frac{x_i}{\sigma_i^2}\sum_i\frac{y_i}{\sigma_i^2} \right) \]

\[ \Delta = \sum_i\frac{1}{\sigma_i^2} \sum_i\frac{x_i^2}{\sigma_i^2} - \left(\sum_i\frac{x_i}{\sigma_i^2}\right)^2 \]

Nimmt man für alle $y_i$ den selben absoluten Fehler an, so lässt sich dieser aus dem Fit bestimmen:

\[ \sigma^2 = \frac{1}{N-2}\sum_i\left(y_i-f(x_i)\right)^2 \]

Die Fehler von $a$ und $b$ ergeben sich mit den üblichen Methoden der Fehlerfortpflanzung aus den $\sigma_i$ bzw. $\sigma$: \[ \sigma_a^2 = \sum_i \sigma_i^2\left(\frac{\partial a}{\partial y_i}\right)^2 = \sum_i \sigma_i^2\left(\frac{1}{\Delta}\left( \frac{1}{\sigma_i^2}\sum_j\frac{x_j^2}{\sigma_j^2}-\frac{x_i^2}{\sigma_i^2}\sum_j\frac{x_j}{\sigma_j^2} \right)\right)^2 =\frac{1}{\Delta}\sum_i\frac{x_i^2}{\sigma_i^2} \] \[ \sigma_b^2 = \sum_i \sigma_i^2\left(\frac{\partial b}{\partial y_i}\right)^2 = \sum_i \sigma_i^2\left( \frac{1}{\Delta}\left( \frac{x_i}{\sigma_i^2}\sum_j\frac{1}{\sigma_j^2}-\frac{1}{\sigma_i^2}\sum_j\frac{x_j}{\sigma_j^2} \right) \right)^2 =\frac{1}{\Delta}\sum_i\frac{1}{\sigma_i^2} \]

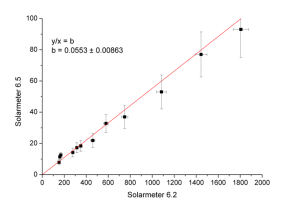

Variante: Nullpunktsgerade

Setzt man $f(x) = mx$ an erhält man

\[ m = \sum_i\frac{x_iy_i}{\sigma_i^2} / \sum_i\frac{x_i^2}{\sigma_i^2} \qquad \qquad m = \frac{\sum_i x_iy_i}{\sum_i x_i^2} \quad(\sigma_i=\sigma) \]

\[ \sigma_y^2 = \frac{1}{N-1}\sum_i\left(y_i-mx_i\right)^2 \]

\[ \sigma_m^2 = \frac{1}{\sum_i\frac{x_i^2}{\sigma_i^2}} \]

Alternativ kann man für jedes Wertepaar $(x_i,y_i)$ das Verhältnis

\[ m_i = \frac{y_i}{x_i} \]

bestimmen. Der Fehler der $m_i$ ist

\[ \sigma_{m_i}^2 = \frac{y_i^2}{x_i^2}\left(\frac{\sigma_{y_i}^2}{y_i^2}-\frac{\sigma_{x_i}^2}{x_i^2}\right) = \frac{1}{k w_i} \]

Der Mittelwert der $m_i$ gewichtet mit den Fehlern $\sigma_i$ (wobei nur der relative Wert $w_i$ relevant ist) lautet ([489Press, W. H., Teukolsky, S. A., Vetterling, W. T., & Flannery, B. P. (2007). Numerical recipes: The art of scientific computing 3rd ed. Cambridge University Press.],S65ff)

\[ \overline m = \frac{\sum_i w_i m_i}{\sum_i w_i} \]

Aus der Streuung der Punkte um die Gerade lässt sich der unkannte Faktor $k$ und somit der absolute Fehler von $m_i$ und $\overline m$ bestimmen:

\[ \sigma = \left(\frac{\sum_i w_i m_i^2}{\sum_i w_i}-m_i^2\right)\frac{N}{N-1} \]

\[ \sigma_{\overline m}^2 = \frac{\sigma^2}{N} \qquad \sigma_{m_i}^2 = \frac{1}{w_i}\frac{\sigma^2\sum_iw_i}{N} \qquad \]

Variante: sowohl x als auch y fehlerbehaftet

Um Daten zu behandeln die sowohl in $x$ als auch $y$ fehlerbehaftet sind, kann der kürzeste Abstand der Punkte zur Gerade minimiert werden (Wolfram Mathworld).

\[ a = -A\pm\sqrt{A^2+1} \qquad A = \frac{1}{2} \frac{\frac{1}{N}\sum_iy_i^2 - \overline y^2 - \frac{1}{N}\sum_ix_i^2 + \overline x^2}{\overline x\overline y - \frac{1}{N}\sum_ix_iy_i}\] \[b = \overline y - a\overline x\]

Oder die vertikalen Abstände gewichtet mit den Fehlern in $x$ und $y$ minimiert werden [489Press, W. H., Teukolsky, S. A., Vetterling, W. T., & Flannery, B. P. (2007). Numerical recipes: The art of scientific computing 3rd ed. Cambridge University Press.]

\[ \chi^2 = \sum\limits_{i=1}^N\frac{(y_i-ax_i - b)^2}{\sigma_{y,i}^2+a^2\sigma_{x,i}^2} \]

Hintergrund: Statistischer Fehler

Ein Gruppe von Werten $w_i$ schwankt um ihren Mittelwert

\[ \overline w = \frac{1}{N}\sum\limits_i^N w_i \qquad \overline w = \sum\limits_i\frac{w_i}{\sigma_i^2} / \sum\limits_i\frac{1}{\sigma_i^2} \]

Wobei der Mittelwert so definiert ist, dass der mittlere quadratische Abstand zum Mittelwert minimal wird: $\sum_i(w_i-\overline w)^2=$ minimal $\Rightarrow \frac{\mathrm{d}}{\mathrm{d}\overline w}\sum_i (w_i-\overline w)^2=0$.

Die Stärke der Schwankung wird durch die Varianz gegeben5)

\[ \mathrm{Var} = \frac{1}{N-1}\sum\limits_i^N \left(w_i - \overline w\right)^2 \]

wobei die Standardabweichung (der Einzelwerte)

\[ \sigma_N = \sqrt{\mathrm{Var}} = \sqrt{\frac{1}{N-1}\sum\limits_i^N \left(w_i - \overline w\right)^2} \]

das Intervall um $\overline w$ angibt, in dem (sofern eine Normalverteilung der Messwerte vorliegt) 68% der Messwerte $w_i$ verteilt sind.

- 68,3% der $w_i$ $\in [\overline w - \sigma,\overline w + \sigma]$

- 95,4% der $w_i$ $\in [\overline w - 2\sigma,\overline w + 2\sigma]$

- 99,7% der $w_i$ $\in [\overline w - 3\sigma,\overline w + 3\sigma]$

Neben der Definition von $\sigma_N$ gibt es auch die Definitionen $\sigma_{N-1}$ und $\sigma_{N-2}$ bei denen $N$ im Nenner jeweils durch $N-1$ bzw. $N-2$ ersetzt wird. Es gilt $\sigma_{N-2}\geq\sigma_{N-1}\geq\sigma_N$. Diese Standardabweichungen werden verwendet wenn nur eine Stichprobe anstelle der Grundgesamheit betracht werden.

Die Standardabweichung des Mittelwerts, auch mittlerer quadratischer Fehler genannt, \[ \sigma_\mathrm{MW} = \frac{\sigma}{\sqrt{N}} \] gibt an wie sich die statistische Streuung der Messwerte als Fehler auf den Mittelwert auswirkt. Die Standardabweichung des Mittelwerts ist deutlich kleiner als die Standardabweichung der Einzelwerte, da sich durch Mittelung über viele Messungen die Unsicherheit verringert.

Hintergrund: Fehlerfortpflanzung

Rechnet man aus zwei (oder mehrere) Messwerten $x\pm\sigma_x$ und $y\pm\sigma_y$ einen neuen Wert $f(x,y)$ aus, so pflanzen sich die Fehler von $x$ und $y$ auf $f$ fort. Der Fehler von $f$ ist6): \[ \sigma_f^2 = \left(\frac{\partial f}{\partial x}\right)^2\sigma_x^2 + \left(\frac{\partial f}{\partial y}\right)^2\sigma_y^2 \] \[ \begin{array}{ll} f = x + y & \Rightarrow \sigma_f^2 = \sigma_x^2 + \sigma_y^2 \\\\ f = x - y & \Rightarrow \sigma_f^2 = \sigma_x^2 - \sigma_y^2 \\\\ f = x \cdot y & \Rightarrow \left(\frac{\sigma_f}{f}\right)^2 = \left(\frac{\sigma_x}{x}\right)^2 + \left(\frac{\sigma_y}{y}\right)^2 \\\\ f = \frac{x}{y} & \Rightarrow \left(\frac{\sigma_f}{f}\right)^2 = \left(\frac{\sigma_x}{x}\right)^2 + \left(\frac{\sigma_y}{y}\right)^2 \end{array} \]

Literatur

[485] Bevington, P. R., & Robinson, K. D. (2002). Data reduction and error analysis for the physical sciences 3rd ed. Mcgraw-Hill Higher Education.

[489] Press, W. H., Teukolsky, S. A., Vetterling, W. T., & Flannery, B. P. (2007). Numerical recipes: The art of scientific computing 3rd ed. Cambridge University Press.